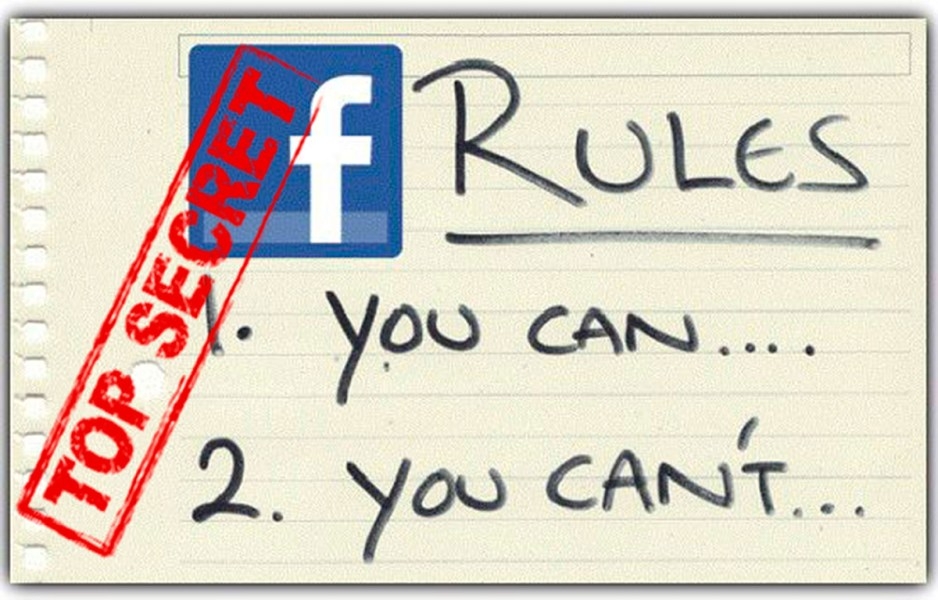

Filtran reglas secretas de Facebook para moderar contenidos

1.400 páginas de reglamentos para los moderadores que evidencian la controvertida política regulatoria de contenido de la popular red social. normas llaman la atención por su escasa eficacia y suponen la eliminación de contenidos sin motivos concretos

publicado en 01 / Jan / 19Empleado de Facebook ha filtrado a The New York Times más de 1.400 páginas de reglamentos para los moderadores que evidencian la controvertida política regulatoria de contenido de la popular red social. Algunas de las normas llaman la atención por su escasa eficacia y suponen la eliminación de contenidos sin motivos concretos. Por otro lado, información que sí debería ser retirada permanece.

Al estudiar los documentos, el medio llegó a la conclusión de que los reglamentos estaban elaborados para angloparlantes que acuden a Google Translate, y que Facebook carece de moderadores que hablen idiomas locales y comprendan contextos que son cruciales para detectar discursos incendiarios en determinados países.

Así salió a la luz que un error de papeleo permitió que el conocido grupo extremista Ma Ba Tha, acusado de fomentar genocidio de los musulmanes en Birmania, permaneciera activo en la plataforma durante meses. Se estima que Facebook prohibió hacer cualquier mención positiva del grupo esta primavera, pero los activistas afirmaron que en la red social había muchos mensajes de apoyo a los extremistas meses después.

Asimismo, The New York Times se percató de que en los reglamentos para los moderadores sobre el discurso de odio en Birmania se indicaba que no eliminaran las publicaciones con apoyo a Ma Ba Tha. La red social corrigió el error solo en respuesta al periódico.

En los países donde la línea entre el extremismo y la política cotidiana es más borrosa, los moderadores de Facebook pueden echarles la mano a uno de los oponentes políticos e influir en la opinión pública. Poco antes de las elecciones en Pakistán, los moderadores recibieron los órdenes de someter a un mayor escrutinio al partido religioso Jamiat Ulema-e-Islam, mientras otro partido religioso, Jamaat-e-Islami, fue considerado como "favorable".

En la India, se aconseja "estar pendiente" de la frase "Free Kashmir" (Cachemira Libre), aunque el lema en sí es legal y se usa entre los activistas, cuyas actividades podrían disminuir por el escrutinio extra del equipo de la red social. Además, en los reglamentos se indica que cualquier comentario crítico sobre la religión viola la legislación nacional y debería ser eliminado, aunque las leyes indias prohíben la blasfemia solo en circunstancias determinadas, como cuando el objetivo es incitar la violencia.

En un documento sobre la situación en los Balcanes, que no ha sido actualizado desde 2016, se explica que el criminal de guerra Ratko Mladic es prófugo, aunque fue arrestado en 2011, y no hay muchos datos sobre los grupos ultranacionalistas que avivan la violencia política en la región.

El periódico también concluyó que en sus archivos internos Facebook tiene una mejor cobertura de los países donde afronta presión gubernamental: en Alemania la red social bloqueó decenas de grupos ultraderechistas, mientras que en Austria solo uno.

En uno de los documentos se explica cómo determinar si las palabras como 'mártir' o 'yihad' aparecen en un contexto afín al terrorismo o las palabras como 'hermano' o 'camarada' cruzan la línea de lo permitido. Lo mismo pasa con emoticonos como el que llora y se ríe a la vez, que podría ser tomado por una señal de 'bullying' o de burlas crueles.

También se ha sabido que en una ocasión los moderadores tenían que eliminar los llamamientos a fin de recaudar fondos para las víctimas de la erupción del volcán en Indonesia porque un copatrocinador estaba en la lista interna de grupos prohibidos